Conduct a 90-minute audit today: list three obstacles, assign one measurable KPI to each, schedule a 7-day micro-test and require documented evidence at test end; you must assign an owner and a deadline to each item.

During diagnosis capture five concrete elements: throughput (units/hour), defect rate (%), cycle time (minutes), customer approval rate (%) and resource hours/day; ensure these columns are included in a spreadsheet and use keyboard macros to cut manual entry time – our internal trial shows a 62% reduction in keystrokes. In physical faults such as water leaks measure liters/hour; a 0.5 L/h leak brought a 12% rise in utility spend. If a target looks impossible, split it into 10% progress milestones and measure the change after each milestone.

Design each micro-test with a falsifiable hypothesis, a control, and two independent metrics that relate directly to revenue or lead time; if results cannot confirm improvement within seven days, escalate to a larger test. Do not fight scope solo: surround experiments with three stakeholders and consult existing guides. If diagnosis is difficult, add an external reviewer and apply 5 Whys to probe deeply. True improvement is seen when both primary metric and cost-per-unit changed together; when clarity comes, document exact steps, timelines and templates, then replicate at scale.

Step 1 – Isolate the Root Cause

Log 12 entries per day for seven consecutive days: timestamp, actor, trigger, observable effect, severity (1–5), metric value, immediate action, and financial impact (USD); use a shared spreadsheet with those exact column headers and a cell for “currently unresolved” flagged True/False.

When a recurring failure appears, perform a five-why chain and a compact fishbone: provide five sequential “why” statements with evidence for each link and a probability score (low/medium/high); annotate whether the root cause is technical, process, vendor, or human and add a one-line mitigation that can be implemented within 72 hours because rapid containment prevents escalation.

If invoices or bills are currently delayed, capture invoice ID, due date, and payment workflow step where the delay occurred; map the delay to customer impact (minutes of downtime or $ lost) and prioritize items with negative financial exposure over $500 per event. Apply a strict reporting style: single-line summary, three supporting data points, owner, and deadline.

Teach the team the questioning sequence and run 15-minute drills twice weekly; use role plays in the midst of simulated incidents so analysts learn to relate symptoms to root causes quickly. Emphasize compassionate feedback when a human error appears: focus on qualities that support correction (motivated analysts, curiosity, kindness) and short learning modules led by annemarie or another coach to build those qualities well.

If elimination seems impossible, document residual risk and design compensating controls with cost and effectiveness estimates (e.g., 30% recurrence reduction for $2,000 upfront and $150/month). Set clear aims: reduce recurrence by 80% within 90 days, state what metrics are going to change, and maintain an abundance of small signals so teams can really see trends and measure progress while overcoming organizational friction.

Map recent failures to identify recurring triggers

Collect the last 12 incidents and log Date, Trigger, Context, Steps taken, Outcome, Severity (1-5), Direct cost USD, Hours lost, Owner, Escalation level; scan system logs across the last 90 days to match events against that list and produce a priority table with frequency and total cost per trigger.

Mark a trigger as recurring when it meets any of these objective thresholds: appears >=3 times within 30 days, represents >=25% of total incidents, or causes >$1,000 cumulative loss; assign an owner who must close the remediation within 48 business hours or the related project will pause.

Create a spreadsheet template with these columns: Date, Trigger, Root-candidate, Where it occurred (service/vendor), Number of users impacted, Severity, Cost USD, Hours lost, Immediate actions, Next actions, Owner, Status. Use automated scans to populate Date, Trigger and Hours lost, then validate manually to achieve full clarity.

Set communication rules: trigger an email to Owner plus two stakeholders when a recurring trigger is detected; include impact numbers, last three occurrences, and the first three recommended actions. Require a 15-minute pause and triage call when a trigger affects >5 users or causes >$500 single-incident loss.

Apply the template to real cases: shane decided to pause a deployment after three payment failures; he emailed ops, created three tickets, and blocked the release until a patch passed a 24-hour smoke test; theyve reduced repeat incidents from 8 to 2 in 60 days using that cadence.

Use non-technical examples to test the process: a course instructor taught herself the new LMS; when her husband changed a shared calendar, students missed a session; implement an automated calendar scan, send an immediate email alert to students within 60 minutes, then log the event as a vendor-sourced issue and check the external источник.

Track three KPIs weekly: recurrence rate (% of incidents that match recurring triggers), MTTR in hours, and number of corrective actions closed within SLA; set a concrete goal to cut recurrence rate by 50% within 90 days. No single fix is guaranteed; combine process changes, ownership, and targeted training to move beyond symptoms and reduce repeat loss.

Ask five direct questions to separate symptoms from cause

Ask these five direct questions and log numeric answers within 48 hours; use them to map symptoms against root causes with at least three data points per item.

Q1 – How often did the issue occur in the last 14 days? Record exact amount and size (minutes, occurrences). If >3 events per week or average event >30 minutes, mark as high frequency. At each entry note moods and emotions on a 1–10 scale and timestamp; this creates a baseline useful when comparing later solutions.

Q2 – When did the pattern begin? Enter month of onset and count elapsed months. Compare workload, sleep hours and major events; if a metric shifted beyond 25% around onset, record the direction of change. Use that timeline to prioritize hypotheses with closest temporal correlation.

Q3 – What happened immediately before most episodes? List actions, locations, people and inputs. Run one small experiment removing a single trigger over two weeks while actively tracking outcomes; avoid changing multiple variables at once. Measure difference in occurrence rate, intensity and signs like teeth grinding or sleep interruptions.

Q4 – What solutions were tried and what changed? Itemize each solution, note duration in days or months, amount of change (percent or 0–10 impact), who provided support and what knowledge gaps remain. Prioritize low-cost experiments that can be repeated; record what you hear from colleagues or clinicians as external data points.

Q5 – How will you know the cause is addressed? Define three measurable metrics: occurrence count per week, a mood score, and a healthy sleep metric. Set target size and timeline (example: 40% reduction within 3 months). Include subjective signals such as feeling motivated, fewer tasks you feel hated about, and an amazing increase in clarity beyond baseline.

Use answers to build a prioritized action list, building one low-cost experiment each week, collect data, share results with a trusted contact so you can hear new perspective and expand knowledge within your world. Fostering mindful tracking and seeking support produces more powerful, durable solutions while avoiding wasted effort on surface symptoms.

Collect the smallest dataset that proves the pattern

Collect exactly 30 labeled cases: 20 positive examples that match the target pattern and 10 negative controls; each entry must include five fields–timestamp, context, action, outcome, confidence–and be labeled by at least two people within 48 hours. Allocate 2 hours per day across a 3-day schedule to gather them.

Use a spreadsheet plus a lightweight labeling tool and keep total dataset size between 30 and 50 rows; larger size dilutes clarity without new signal. Log hours spent per entry; keep context under 300 characters to reduce noise and aid quick learning. Look at duplicates and near-duplicates; remove them to preserve independence of observations.

Ask them to attach a one-line feel tag (positive/negative/neutral) and a single gratitude note when applicable; these subjective fields help identify bias and remind evaluators that apparent beauty or novelty sometimes seemed misleading. If a pattern isnt visible at 30 examples, treat that as a lesson, not a failure.

Have 3 people label each row independently during a scheduled block so majority vote resolves ambiguity; mentally rotate labelers after several hours to avoid shared bias from being in the same space. If labelers are concerned about time, shorten each session to 45 minutes and return later; sitting too long reduces care and increases negative labels.

Track tools used (spreadsheet, CSV export, quick label UI) and timestamp each change; keep a changelog that identified who edited what and when. If signals identified span decades in historical logs, expand sample size in middle ranges to capture rare events; rather than chasing massive datasets, prioritize unique counterexamples that clarify boundary conditions and expose the real lesson.

Reserve 1 hour at the end of each day to review them and write a one-sentence lesson that will remind team members what seemed important; treat that note as a micro-learning artifact to boost creativity. Express gratitude to labelers; small acknowledgements improve care and reduce negative attitudes that can skew labels and how people feel about the task.

| Field | タイプ | 例 |

|---|---|---|

| timestamp | 国際標準化機構 | 2025-11-19T09:30Z |

| context | string (≤300) | sitting in middle row, low light |

| アクション | string | pressed button A |

| 結果 | label | pattern present |

| confidence | 0-1 | 0.8 |

| 感じる | tag | neutral |

| ノート | string | gratitude: quick help appreciated |

List assumptions to disprove with quick checks

3つの迅速なチェックを実行します。48時間の着陸ページ煙テスト、7日間のコホート定着パルス、および15分間の顧客インタビューです。

A/Bテストで製品機能の仮説を検証する:バリアントとコントロールに均等なトラフィックを割り当て、各アームで少なくとも100件のコンバージョンをターゲットにします。ベースラインのコンバージョン率が2%の場合、各アームで約5,000ユーザーを収集します。p<0.05とpower 0.8を棄却ルールとして使用します。事前の登録基準に達した場合にのみ早期に停止します。

クイックマーケットチェック:最小限のランディングページを公開し、予想されるバイヤーペルソナに対するターゲティング広告に$50を費やします。48時間以内に登録率、顧客獲得単価、広告のクリックから登録までのファネルを追跡します。 次の行動を決定するために、公開されている業界ベンチマークと比較します。

製品利用の仮定:一貫したエンゲージメント期間を測定する - 0-7日間のアクティブ率、30日間の定着率、および毎週の解約率。明確に定義されたコホートの中で変革された行動がSegmentationによって示されない限り、短期指標の絶対的な3%のランダムな上昇をノイズとして扱う。

ユーザービリーフテスト:直近5人のユーザーにコンタクトし、認識された価値、支払い意欲、そしてプランを切り替える理由についてクローズドな質問を投げかけます。以前に解約意図を示したユーザーは高価値です。その回答は、摩擦と健全な需要シグナルを明らかにします。

Technical and ops checks: deploy behind a switch flag and force 1% traffic through the new path to monitor latency, error rate, and feature toggles. Keep observability tight; log every exception tied to the change so engineering can isolate issues quickly.

価格と提供に関する仮定: 3つの価格で同一メッセージングを用いて価格感度マイクロテストを実施し、コンバージョンリフトと訪問者あたりの収益を観察します。訪問者あたりの収益がより高い価格で少なくとも8%に上昇しない場合は、価格の仮定を却下します。

仮説を維持または破棄するための決定ルール:少なくとも2つの独立した指標で一貫した改善が見られること、新たな運用上の問題がないこと、および顧客によって記述される定性的な確認が必要です。これらが失敗した場合、戦略を変更します。成功した場合、サンプルを拡大し、90日を超える長期的な影響を追跡します。

監視する行動シグナル: NPS の変化、サポートボリューム、払い戻しリクエスト、および利用深度。すべてがネガティブな傾向にある場合、製品と市場のミスマッチを示します。すべてが肯定的な傾向にある場合は、仮説がベースラインよりも優れており、スケールできることを示唆します。

コミュニケーションと倫理:実験では透明性を保ち、オプトアウトの機会を提供し、ユーザーに連絡する際には思いやりを持って対応してください。テストを文書化し、結果を社内公開し、チームが重複した努力を避け、その結果から学ぶことができるようにレジストリを維持してください。

ステップ 2 – 実行可能な修正を生成する

所有者を1人割り当て、7日間のテスト期間を設定してください。明確な仮説、数値による成功基準、および実行可能なロールバックプランを備えた3つの修正を提供する必要があります。

- 仮説と指標: 一行でアイデアを述べ、期待される影響の簡単な紹介を記述してください。ベースライン(14日間の平均値、サンプルサイズ、SD)を把握し、絶対的なデルタとパーセント変化として予想される変化を表現する:ターゲットは+0.10絶対または+15%相対のこと。注釈には、収集場所と集約レベル(ユーザー、セッション、トランザクション)を含め、ベースラインとの簡単な比較を行い、予想される違いを示すこと。

- デザインアーティファクト: UIまたはフローを説明するスクリーンショット、コピー、承認テスト、ビデオを添付してください。 現在の要素と提案された要素、正確なコピーの変更点、ピクセルまたはミリ秒の許容範囲、および承認者リストを含むコンパクトなテーブルを含めてください。

- 実装と所有権: オーナー名 (例: shawn)、ブランチ、デプロイウィンドウ、ビルドタグ、およびロールバック基準。メトリクスが目標値より少なくとも50%改善しない場合は、48時間以内にドキュメント化されたロールバックスクリプトを実行します。正確なコマンド、監視クエリ、および復元を確認するためのスモークテストを含めてください。

- 実行と分析: 80% パワーをα 0.05としてパワー計算を用いた並列A/Bテストを実行し、場所とユーザーレベルでセグメント分けする。深呼吸をしてから徹底的に分析してください。小規模セグメントではノイズが見られるかもしれませんが、効果が劇的に大きい場合は、フルローンチ前に検証コホートを実行してください。絶対差、パーセント変化、95% CIを使用した比較チャートを使用してください。

- ドキュメントとフォローアップ: コミットノートを完全に注釈し、何がうまくいったか、うまくいかなかったか、ロードマップの項目を述べた、思慮深い概要を公開してください。短縮版で調査結果を提示し、レビュー担当者の役に立つ動画やログを添付してください。各障害を克服した方法、次の3つのタスクの担当者、締め切りをリスト化してください。

一日にテストできる制約ベースのソリューションを作成する

単一の指標を分離し、24時間以内に影響を測定する、1日間の制約付き実験を実行します。

-

仮説チェックアウトのフィールド数を6から3に減らし、24時間以内に≥10%の完了率の向上が期待されます。ベースラインのコンバージョン率、目標の向上、および許容される誤差範囲を明示してください。

-

チームとツール必要最小限のチームを編成します - 変更を実行できるエンジニア1人、デザイナー1人、アナリスト1人。機能フラグシステムを使用し、トラフィックを50/50で分割します。分析、エラーロギング、および決済システムが有効になっていることを確認します。

-

サンプルサイズもし日次のセッション数が10,000の場合、バリアントごとに5,000を割り当てます。95%の信頼度で5%の相対的なリフトを検出するには、アームごとに約4,000イベントが必要です。トラフィックが少ない場合は、テスト期間を延長してそのサンプルサイズに達してください。

-

実装チェックリスト

- 要素を1つだけ変更します(フィールドカウント)ことで、帰属を明確にします。

- テストページに、目に見える変更を説明する一文の紹介文を配置してください。

- 実行中は外部キャンペーンを無効にして、ノイズを避けてください。

- リリースプレーンで安全なロールバックフラグとホットフィックスパスを用意する。

- 内部テスト版を公開し、テストタイプラベルでイベントにタグ付けしてください。

-

Metrics and analysis: conversion の定義は、completed checkout ÷ sessions です。両側検定の 95% CI を使用し、絶対値と相対値の効果量を報告し、明確性を維持するために、生のイベント数と分析処理済みの数値の両方を示してください。

-

コミュニケーションテストウィンドウ、期待される指標、および異常なエラーが発生した場合のロールバックの約束を、製品、運用、および法務関係者に通知します。ローンチ後すぐに進捗状況を示すライブダッシュボードを共有します。

-

意思決定規則

- lift ≥ target であり、p ≤ 0.05 の場合:メインバージョンへの変更を推進し、変更されたコードとデザインを記録してください。

- If lift < target or noisy: mark as missed opportunity, capture hypotheses about why, and schedule a next quick experiment that tweaks one element of the current change.

記事に二段構成の研究ノートを含めます。開始時の文脈、テストが明らかにした現実、参加者の感想、および期待どおりに動作したシステムについて言及してください。最大の洞察と、実行すべき次のテストの種類を具体的に示し、簡潔で具体的で、行動に移しやすい文章に保ち、チームがこのアプローチを繰り返す意欲を維持できるようにします。

Rank fixes by speed-to-test and resource need

48時間以内に検証可能で、16人時間未満を必要とする修正を優先する。トリアージを実行する。 火曜日 and assign a target tester+dev pair for each item. Allocate 半分 of weekly QA capacity to these fast experiments and use a numeric 比較 score = (impact_score × confidence %) / (time_to_test_days × person_days) で候補者をソートします。次のスプリントのために上位8~12名を選び、7~14日ごとに測定可能な成果を示すことができます。

高速 = テストに0〜2日、≤ 2人日かかる。 middle = 3–7日 ≤ 5人日、遅い = >7日または>5人日。チケットが できない 7日以内にテストされるか stuck waiting on an externally 所有されているAPIの場合、速度が遅いとマークし、必要な軽減策(モック、コントラクトテスト、またはロールバック計画)を追加してください。ドキュメントを direction and expected metric change for each fix as 記載されている チケットヘッダーに記載することで、関係者やその コミュニティ 優先順位付けを信頼でき、複製できます。 比較 later.

具体的な段階的操作目標を設定する:中央値テスト時間= 24時間、目標信頼度≥ 60%、週4回の高速テストのベンチ、および遅い項目に対してロードマップ容量20%を超えないようにする。 スタートアップ or R&D sprint. Small experiments often スパーク 養子縁組; それを定量化する 意味 修正ごとに1つの主要メトリックと2つの二次メトリックを追跡することで、発見を促します。 マインドセット むしろ、 感情的 単一のチケットへの添付に限定されます。 研究 the simplest test that creates actionable data, because rapid feedback 作成 信頼と力が明確である 行動。データが新たに到着するまでは、ランキングを変更しないでください。 todays cadence, エスカレーションは48時間以上ブロックされた場合、またはメトリクスが1レベル低下した場合のみ実施する。 instead 仮説を議論するのに時間を費やすのではなく、方向性を証明する最小限の実験を実行してください。

4 Proven Steps to Turn Problems into a Guide for Success">

4 Proven Steps to Turn Problems into a Guide for Success">

共依存の関係性 – 兆候と回復のヒント">

共依存の関係性 – 兆候と回復のヒント">

恋人大好きだけど、別れるべき時?サイン10個と決める方法">

恋人大好きだけど、別れるべき時?サイン10個と決める方法">

私たちは同じ人をデートしているのだろうか?オンライングループのダークサイド">

私たちは同じ人をデートしているのだろうか?オンライングループのダークサイド">

私自身を好きになれていないのに、愛されることはできるのか? 自己肯定感と人間関係">

私自身を好きになれていないのに、愛されることはできるのか? 自己肯定感と人間関係">

テキストは浮気ですか?Facebookでのテキスト浮気について解説">

テキストは浮気ですか?Facebookでのテキスト浮気について解説">

3 Effective Messages to Send a Woman with No Bio on a Dating App">

3 Effective Messages to Send a Woman with No Bio on a Dating App">

Why People Behave Badly on Dating Apps – Causes, Psychology & Solutions">

Why People Behave Badly on Dating Apps – Causes, Psychology & Solutions">

Why Men Don’t Ask Questions – Single Woman’s Guide">

Why Men Don’t Ask Questions – Single Woman’s Guide">

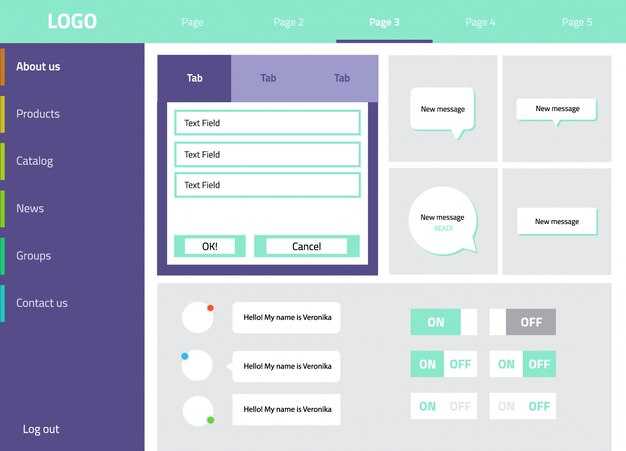

Dialog Window – UI Design, Examples & Accessibility Best Practices">

Dialog Window – UI Design, Examples & Accessibility Best Practices">

Overcome Codependency – Practical Tips to Break Free">

Overcome Codependency – Practical Tips to Break Free">