Conduct a 90-minute audit today: list three obstacles, assign one measurable KPI to each, schedule a 7-day micro-test and require documented evidence at test end; you must assign an owner and a deadline to each item.

During diagnosis capture five concrete elements: throughput (units/hour), defect rate (%), cycle time (minutes), customer approval rate (%) and resource hours/day; ensure these columns are included in a spreadsheet and use keyboard macros to cut manual entry time – our internal trial shows a 62% reduction in keystrokes. In physical faults such as water leaks measure liters/hour; a 0.5 L/h leak brought a 12% rise in utility spend. If a target looks impossible, split it into 10% progress milestones and measure the change after each milestone.

Design each micro-test with a falsifiable hypothesis, a control, and two independent metrics that relate directly to revenue or lead time; if results cannot confirm improvement within seven days, escalate to a larger test. Do not fight scope solo: surround experiments with three stakeholders and consult existing guides. If diagnosis is difficult, add an external reviewer and apply 5 Whys to probe deeply. True improvement is seen when both primary metric and cost-per-unit changed together; when clarity comes, document exact steps, timelines and templates, then replicate at scale.

Step 1 – Isolate the Root Cause

Log 12 entries per day for seven consecutive days: timestamp, actor, trigger, observable effect, severity (1–5), metric value, immediate action, and financial impact (USD); use a shared spreadsheet with those exact column headers and a cell for “currently unresolved” flagged True/False.

When a recurring failure appears, perform a five-why chain and a compact fishbone: provide five sequential “why” statements with evidence for each link and a probability score (low/medium/high); annotate whether the root cause is technical, process, vendor, or human and add a one-line mitigation that can be implemented within 72 hours because rapid containment prevents escalation.

If invoices or bills are currently delayed, capture invoice ID, due date, and payment workflow step where the delay occurred; map the delay to customer impact (minutes of downtime or $ lost) and prioritize items with negative financial exposure over $500 per event. Apply a strict reporting style: single-line summary, three supporting data points, owner, and deadline.

Teach the team the questioning sequence and run 15-minute drills twice weekly; use role plays in the midst of simulated incidents so analysts learn to relate symptoms to root causes quickly. Emphasize compassionate feedback when a human error appears: focus on qualities that support correction (motivated analysts, curiosity, kindness) and short learning modules led by annemarie or another coach to build those qualities well.

If elimination seems impossible, document residual risk and design compensating controls with cost and effectiveness estimates (e.g., 30% recurrence reduction for $2,000 upfront and $150/month). Set clear aims: reduce recurrence by 80% within 90 days, state what metrics are going to change, and maintain an abundance of small signals so teams can really see trends and measure progress while overcoming organizational friction.

Map recent failures to identify recurring triggers

Collect the last 12 incidents and log Date, Trigger, Context, Steps taken, Outcome, Severity (1-5), Direct cost USD, Hours lost, Owner, Escalation level; scan system logs across the last 90 days to match events against that list and produce a priority table with frequency and total cost per trigger.

Mark a trigger as recurring when it meets any of these objective thresholds: appears >=3 times within 30 days, represents >=25% of total incidents, or causes >$1,000 cumulative loss; assign an owner who must close the remediation within 48 business hours or the related project will pause.

Create a spreadsheet template with these columns: Date, Trigger, Root-candidate, Where it occurred (service/vendor), Number of users impacted, Severity, Cost USD, Hours lost, Immediate actions, Next actions, Owner, Status. Use automated scans to populate Date, Trigger and Hours lost, then validate manually to achieve full clarity.

Set communication rules: trigger an email to Owner plus two stakeholders when a recurring trigger is detected; include impact numbers, last three occurrences, and the first three recommended actions. Require a 15-minute pause and triage call when a trigger affects >5 users or causes >$500 single-incident loss.

Apply the template to real cases: shane decided to pause a deployment after three payment failures; he emailed ops, created three tickets, and blocked the release until a patch passed a 24-hour smoke test; theyve reduced repeat incidents from 8 to 2 in 60 days using that cadence.

Use non-technical examples to test the process: a course instructor taught herself the new LMS; when her husband changed a shared calendar, students missed a session; implement an automated calendar scan, send an immediate email alert to students within 60 minutes, then log the event as a vendor-sourced issue and check the external источник.

Track three KPIs weekly: recurrence rate (% of incidents that match recurring triggers), MTTR in hours, and number of corrective actions closed within SLA; set a concrete goal to cut recurrence rate by 50% within 90 days. No single fix is guaranteed; combine process changes, ownership, and targeted training to move beyond symptoms and reduce repeat loss.

Ask five direct questions to separate symptoms from cause

Ask these five direct questions and log numeric answers within 48 hours; use them to map symptoms against root causes with at least three data points per item.

Q1 – How often did the issue occur in the last 14 days? Record exact amount and size (minutes, occurrences). If >3 events per week or average event >30 minutes, mark as high frequency. At each entry note moods and emotions on a 1–10 scale and timestamp; this creates a baseline useful when comparing later solutions.

Q2 – When did the pattern begin? Enter month of onset and count elapsed months. Compare workload, sleep hours and major events; if a metric shifted beyond 25% around onset, record the direction of change. Use that timeline to prioritize hypotheses with closest temporal correlation.

Q3 – What happened immediately before most episodes? List actions, locations, people and inputs. Run one small experiment removing a single trigger over two weeks while actively tracking outcomes; avoid changing multiple variables at once. Measure difference in occurrence rate, intensity and signs like teeth grinding or sleep interruptions.

Q4 – What solutions were tried and what changed? Itemize each solution, note duration in days or months, amount of change (percent or 0–10 impact), who provided support and what knowledge gaps remain. Prioritize low-cost experiments that can be repeated; record what you hear from colleagues or clinicians as external data points.

Q5 – How will you know the cause is addressed? Define three measurable metrics: occurrence count per week, a mood score, and a healthy sleep metric. Set target size and timeline (example: 40% reduction within 3 months). Include subjective signals such as feeling motivated, fewer tasks you feel hated about, and an amazing increase in clarity beyond baseline.

Use answers to build a prioritized action list, building one low-cost experiment each week, collect data, share results with a trusted contact so you can hear new perspective and expand knowledge within your world. Fostering mindful tracking and seeking support produces more powerful, durable solutions while avoiding wasted effort on surface symptoms.

Collect the smallest dataset that proves the pattern

Collect exactly 30 labeled cases: 20 positive examples that match the target pattern and 10 negative controls; each entry must include five fields–timestamp, context, action, outcome, confidence–and be labeled by at least two people within 48 hours. Allocate 2 hours per day across a 3-day schedule to gather them.

Use a spreadsheet plus a lightweight labeling tool and keep total dataset size between 30 and 50 rows; larger size dilutes clarity without new signal. Log hours spent per entry; keep context under 300 characters to reduce noise and aid quick learning. Look at duplicates and near-duplicates; remove them to preserve independence of observations.

Ask them to attach a one-line feel tag (positive/negative/neutral) and a single gratitude note when applicable; these subjective fields help identify bias and remind evaluators that apparent beauty or novelty sometimes seemed misleading. If a pattern isnt visible at 30 examples, treat that as a lesson, not a failure.

Have 3 people label each row independently during a scheduled block so majority vote resolves ambiguity; mentally rotate labelers after several hours to avoid shared bias from being in the same space. If labelers are concerned about time, shorten each session to 45 minutes and return later; sitting too long reduces care and increases negative labels.

Track tools used (spreadsheet, CSV export, quick label UI) and timestamp each change; keep a changelog that identified who edited what and when. If signals identified span decades in historical logs, expand sample size in middle ranges to capture rare events; rather than chasing massive datasets, prioritize unique counterexamples that clarify boundary conditions and expose the real lesson.

Reserve 1 hour at the end of each day to review them and write a one-sentence lesson that will remind team members what seemed important; treat that note as a micro-learning artifact to boost creativity. Express gratitude to labelers; small acknowledgements improve care and reduce negative attitudes that can skew labels and how people feel about the task.

| Field | Tipo | Ejemplo |

|---|---|---|

| timestamp | ISO | 2025-11-19T09:30Z |

| context | string (≤300) | sitting in middle row, low light |

| acción | string | pressed button A |

| resultado | label | pattern present |

| confianza | 0-1 | 0.8 |

| siente | tag | neutral |

| nota | string | gratitud: ayuda rápida apreciada |

Listar suposiciones para desacreditar con verificaciones rápidas

Realice tres comprobaciones rápidas: una prueba de humo de aterrizaje de 48 horas, un pulso de retención de cohortes de 7 días y una entrevista con el cliente de 15 minutos.

Validar una suposición de una función de producto con una prueba A/B: asignar tráfico igual a la variante y al control, apuntar a al menos 100 conversiones por rama; si la tasa de conversión base es 2%, recopilar ~5.000 usuarios por rama. Utilizar p<0.05 y potencia 0.8 como reglas de rechazo; detenerse temprano solo cuando se cumplan los criterios pre-registrados.

Revisión rápida del mercado: publicar una página de destino mínima e invertir $50 en anuncios segmentados alrededor de la persona compradora esperada; rastrear la tasa de registro, el costo por adquisición y el embudo de clics en el anuncio al registro dentro de las 48 horas. Comparar los resultados con los puntos de referencia de la industria publicados para decidir la siguiente acción.

Suposición de uso del producto: medir ventanas de compromiso consistentes: tasa de actividad del día 0 al 7, retención del día 30 y abandono semanal. Tratar un aumento absoluto aleatorio de 3% en métricas a corto plazo como ruido a menos que la segmentación muestre un comportamiento transformado entre un grupo definido.

Pruebas de creencias del usuario: contacte al menos a cinco usuarios recientes; haga preguntas cerradas sobre el valor percibido, la disposición a pagar y qué los haría cambiar de plan. Cualquier persona con una intención de cancelación previa es de alto valor; esas respuestas revelarán fricciones y señales de demanda saludables.

Verificaciones técnicas y de operaciones: implementar detrás de un indicador de conmutador y forzar el tráfico 1% a través de la nueva ruta para monitorear la latencia, la tasa de error y los interruptores de función. Mantener la observabilidad ajustada; registrar cada excepción relacionada con el cambio para que la ingeniería pueda aislar los problemas rápidamente.

Supuestos de precio y oferta: realizar una microprueba de sensibilidad de precios en tres precios con mensajes idénticos, observar el aumento de la conversión y los ingresos por visitante. Si los ingresos por visitante no aumentan al menos 8% a un precio más alto, rechazar el supuesto de precios.

Reglas de decisión para mantener o descartar una suposición: requieren una mejora consistente en al menos dos métricas independientes, ausencia de nuevos problemas operativos y confirmación cualitativa descrita por los clientes. Si esto falla, cambie de estrategia; si pasa, amplíe la muestra y realice un seguimiento del impacto a largo plazo más allá de los 90 días.

Señales de comportamiento a monitorear: cambio en NPS, volumen de soporte, solicitudes de reembolso y profundidad de uso. Todo lo que tiende a negativo indica un desajuste producto-mercado; todo lo que tiende a positivo sugiere que la hipótesis es mejor que la línea de base y puede escalarse.

Comunicación y ética: sea transparente en los experimentos, ofrezca la opción de exclusión y mantenga la compasión al contactar a los usuarios. Documente las pruebas, publique los resultados internamente y mantenga un registro para que los equipos eviten esfuerzos duplicados y aprendan de esos resultados.

Paso 2: Generar soluciones prácticas

Asignar un propietario y una ventana de prueba de 7 días: entregar tres correcciones con una hipótesis clara, criterios de éxito numéricos y un plan de reversión ejecutable.

- Hipótesis y métricas: Escribe una idea de una línea y una breve introducción al impacto esperado. Conociendo la línea de base (promedio de 14 días, tamaño de la muestra, DE), expresa el cambio esperado como delta absoluto y cambio porcentual: objetivo +0.10 absoluto o +15% relativo. Las notas deben incluir la ubicación de la recopilación y el nivel de agregación (usuario, sesión, transacción) y una comparación simple con la línea de base que muestre la diferencia esperada.

- Artefactos de diseño: Adjunta capturas de pantalla, copia, pruebas de aceptación y videos que demuestren la interfaz de usuario o el flujo. Incluye una tabla compacta que liste los elementos actuales frente a los propuestos, los cambios exactos en la copia, las tolerancias de píxeles o milisegundos, y quién aprobará.

- Implementación y propiedad: Nombre del propietario (ejemplo: shawn), rama, ventana de despliegue, etiqueta de compilación y criterios de reversión. Si la métrica no mejora al menos en 50% del objetivo dentro de las 48 horas, ejecute el script de reversión documentado. Incluya los comandos exactos, las consultas de supervisión y las pruebas de humo para verificar la restauración.

- Ejecución y análisis: Ejecute A/B en paralelo con cálculo de potencia apuntando a una potencia de 80% con alfa 0.05; segmente por ubicación y nivel de usuario. Tome una respiración, luego analice profundamente; aunque los segmentos pequeños puedan mostrar ruido, si el efecto es dramáticamente grande, ejecute un grupo de validación antes de la implementación completa. Use gráficos de comparación con diferencia absoluta, cambio porcentual e IC del 95%.

- Documentación y seguimiento: Anota completamente las notas de commit y publica un resumen reflexivo que indique qué funcionó, qué no, y elementos del plan de ruta. Presenta los hallazgos con una breve presentación y adjunta cualquier video o registro que ayude a los revisores. Enumera los medios para superar cada obstáculo, los responsables de las próximas tres tareas y los plazos.

Crea soluciones basadas en restricciones que puedas probar en un día

Realice un experimento restringido de un día que aísle una sola métrica y mida el impacto dentro de las 24 horas.

-

HipótesisReducir los campos de pago de 6 a 3 y esperar un aumento de finalización de ≥10% en 24 horas; indicar la tasa de conversión de referencia, el aumento objetivo y los márgenes de error aceptables.

-

Equipo y herramientasreunir una tripulación mínima: un ingeniero dispuesto a impulsar el cambio, un diseñador y un analista. Utilizar un sistema de feature-flag y dividir el tráfico 50/50. Asegurarse de que los sistemas de analítica, registro de errores y pagos estén activos.

-

Tamaño de muestrasi las sesiones diarias = 10,000, asignar 5,000 por variante; para detectar un aumento relativo de 5% con una confianza del 95% necesita ~4,000 eventos por brazo. Si el tráfico es menor, prolongar la ventana de prueba para alcanzar esa muestra.

-

Lista de verificación de implementación

- Cambiar un elemento solo (conteo de campos) para mantener la atribución clara.

- Coloque una introducción de una oración en la página de prueba que indique el cambio visible.

- Desactiva las campañas externas durante la ejecución para evitar ruidos.

- Preparar una marca de retroceso segura y un camino de corrección rápida en el plano de lanzamiento.

- Publicar una versión de prueba interna y etiquetar los eventos con una etiqueta de tipo de prueba.

-

Métricas y análisis: defina conversion = facturación completada ÷ sesiones. Use una IC bilateral del 95%, reporte tamaños de efecto absolutos y relativos, y muestre conteos de eventos brutos más números analizados para mantener la claridad.

-

Comunicación: notificar a las partes de producto, operaciones y legales con la ventana de prueba, las métricas esperadas y la promesa de revertir en caso de errores anómalos. Compartir un panel de control en vivo que muestre el progreso poco después del lanzamiento.

-

Reglas de decisión

- Si lift ≥ objetivo y p ≤ 0.05: promover el cambio a la versión principal y documentar el fragmento de código y el diseño que cambiaron.

- Si ascensor < objetivo o ruidoso: marcar como una oportunidad perdida, capturar hipótesis sobre por qué, y programar un próximo experimento rápido que ajuste un elemento del cambio actual.

Incluir una nota de investigación de dos párrafos en el artículo: contexto inicial, qué realidades reveló la prueba, qué sintieron los participantes y qué sistemas se comportaron como se esperaba. Mencionar la mayor revelación y el tipo exacto de prueba siguiente a realizar; mantener la redacción breve, concreta y fácil de aplicar para que los equipos sigan entusiasmados con la posibilidad de repetir el enfoque.

Ordenar las correcciones por velocidad de prueba y necesidad de recursos

Priorizar las correcciones que puedan ser validadas dentro de las 48 horas y que requieran menos de 16 horas de trabajo de una persona; realizar el triage en martes y asignar un par de prueba+desarrollo para cada elemento. Asignar medio de la capacidad de control de calidad semanal a estos experimentos rápidos y use un numérico comparación score = (impact_score × confidence %) / (time_to_test_days × person_days) para ordenar candidatos; elija los 8–12 principales para el próximo sprint para que pueda mostrar resultados medibles cada 7–14 días.

Use three buckets with clear thresholds: Fast = 0–2 days to test ≤ 2 person-days, middle = 3–7 días ≤ 5 días persona, Lento = >7 días o >5 días persona. Si un ticket no puede debe ser probado dentro de los 7 días o es atascado esperando en un externamente API propiedad, márquelo como Lento y agregue una mitigación requerida (mock, prueba de contrato o plan de reversión). Documente el dirección y cambio métrico esperado para cada corrección como descrito en el encabezado del ticket para que los interesados y el comunidad se puede confiar en la priorización y replicar el comparación más tarde.

Establecer objetivos operativos concretos: tiempo medio de prueba = 24 horas, confianza objetivo ≥ 60%, banco de 4 pruebas rápidas/semana, y no más de 20% de capacidad de la hoja de ruta en los elementos Lentos para una start-up or R&D sprint. Small experiments often chispa adopci{ - Point 1 - Point 2 Significado by tracking one primary metric per fix and two secondary metrics. Fomentar un descubrimiento mente en lugar de un emocional adjunto a cualquier ticket único; research la prueba más sencilla que crea datos procesables, porque la retroalimentación rápida crea confianza y fuerzas claras acciones. No se debe cambiar la clasificación a menos que lleguen nuevos datos; en todays cadencia, escalar solo cuando esté bloqueado por más de 48 horas o cuando las métricas bajen un nivel; en lugar de debatir hipotéticos, realiza el experimento más pequeño que demuestre la dirección.

4 Pasos Probados para Convertir Problemas en una Guía para el Éxito">

4 Pasos Probados para Convertir Problemas en una Guía para el Éxito">

Codependency in Relationships – Signs & Recovery Tips">

Codependency in Relationships – Signs & Recovery Tips">

I Love My Boyfriend but Is It Time to Break Up? 10 Signs & How to Decide">

I Love My Boyfriend but Is It Time to Break Up? 10 Signs & How to Decide">

Are We Dating the Same Guy? The Dark Side of Online Groups">

Are We Dating the Same Guy? The Dark Side of Online Groups">

Can I Be Loved If I Don’t Like Myself? Self-Esteem & Relationships">

Can I Be Loved If I Don’t Like Myself? Self-Esteem & Relationships">

Is Texting Cheating? Text Cheating on Facebook Explained">

Is Texting Cheating? Text Cheating on Facebook Explained">

![3 Mensajes Efectivos para Enviar a una Mujer Sin Bio en una App de CitasHave you ever stumbled upon a profile on a dating app that's… sparse? Like, really sparse? No bio, maybe a couple of pictures, and you're left wondering, “Is this a bot? A ghost? Or just someone who believes in letting their pictures do the talking?”While a lack of information can be intriguing (a mystery!), it can also be a hurdle when it comes to sparking a connection. You don't have much to work with, so you need to be creative and strategic with your opening message.Here are 3 effective messages to send a woman with no bio on a dating app, along with explanations of why they work:**1. The Observational Opener**This approach focuses on something you *did* notice about her profile – her photos. It shows you paid attention and allows you to start a conversation based on shared interests or a vibe you picked up.*Example:* "Hey! Love the [location in one of her photos]. Been there myself! What’s your favorite thing to do in [location]?”*Why it works:* It's low-pressure, shows you’re observant, and provides an easy conversation starter.**2. The Playful Curiosity Approach**If you’re feeling a bit bolder, you can lean into the lack of information with a playful question. This shows you're not afraid to be a little cheeky and invites her to share something about herself.*Example:* "No bio, huh? Clearly, you're a woman of secrets. 😉 What’s one thing you’re surprisingly good at?”*Why it works:* It’s lighthearted, breaks the ice, and demonstrates a sense of humor.**3. The Direct & Engaging Question**Sometimes, simplicity is key. Ask an open-ended question that encourages her to elaborate and reveals a bit about her personality.*Example:* "What's one thing that's made you smile today?”*Why it works:* It’s easy to answer, positive, and can lead to a genuine connection.**Important Considerations:*** **Profile Pictures:** Really analyze her pictures. Look for clues about her interests, hobbies, or travel destinations. This can provide valuable conversation starters.* **Be Respectful:** Even if she has a minimal profile, treat her with respect and avoid making assumptions or being overly forward.* **Don’t Be Discouraged:** It might take a few tries to get a response. Not everyone is active on dating apps or feels comfortable sharing a lot of information upfront.Ultimately, the best message is one that is genuine, engaging, and shows you’ve taken the time to look at her profile (even if it's brief!). Good luck! 3 Mensajes Efectivos para Enviar a una Mujer Sin Bio en una App de CitasHave you ever stumbled upon a profile on a dating app that's… sparse? Like, really sparse? No bio, maybe a couple of pictures, and you're left wondering, “Is this a bot? A ghost? Or just someone who believes in letting their pictures do the talking?”While a lack of information can be intriguing (a mystery!), it can also be a hurdle when it comes to sparking a connection. You don't have much to work with, so you need to be creative and strategic with your opening message.Here are 3 effective messages to send a woman with no bio on a dating app, along with explanations of why they work:**1. The Observational Opener**This approach focuses on something you *did* notice about her profile – her photos. It shows you paid attention and allows you to start a conversation based on shared interests or a vibe you picked up.*Example:* "Hey! Love the [location in one of her photos]. Been there myself! What’s your favorite thing to do in [location]?”*Why it works:* It's low-pressure, shows you’re observant, and provides an easy conversation starter.**2. The Playful Curiosity Approach**If you’re feeling a bit bolder, you can lean into the lack of information with a playful question. This shows you're not afraid to be a little cheeky and invites her to share something about herself.*Example:* "No bio, huh? Clearly, you're a woman of secrets. 😉 What’s one thing you’re surprisingly good at?”*Why it works:* It’s lighthearted, breaks the ice, and demonstrates a sense of humor.**3. The Direct & Engaging Question**Sometimes, simplicity is key. Ask an open-ended question that encourages her to elaborate and reveals a bit about her personality.*Example:* "What's one thing that's made you smile today?”*Why it works:* It’s easy to answer, positive, and can lead to a genuine connection.**Important Considerations:*** **Profile Pictures:** Really analyze her pictures. Look for clues about her interests, hobbies, or travel destinations. This can provide valuable conversation starters.* **Be Respectful:** Even if she has a minimal profile, treat her with respect and avoid making assumptions or being overly forward.* **Don’t Be Discouraged:** It might take a few tries to get a response. Not everyone is active on dating apps or feels comfortable sharing a lot of information upfront.Ultimately, the best message is one that is genuine, engaging, and shows you’ve taken the time to look at her profile (even if it's brief!). Good luck!](https://soulmatcher.app/wp-content/images/3-effective-messages-to-send-a-woman-with-no-bio-on-a-dating-app.jpg) 3 Mensajes Efectivos para Enviar a una Mujer Sin Bio en una App de Citas

Have you ever stumbled upon a profile on a dating app that's… sparse? Like, really sparse? No bio, maybe a couple of pictures, and you're left wondering, “Is this a bot? A ghost? Or just someone who believes in letting their pictures do the talking?”

While a lack of information can be intriguing (a mystery!), it can also be a hurdle when it comes to sparking a connection. You don't have much to work with, so you need to be creative and strategic with your opening message.

Here are 3 effective messages to send a woman with no bio on a dating app, along with explanations of why they work:

**1. The Observational Opener**

This approach focuses on something you *did* notice about her profile – her photos. It shows you paid attention and allows you to start a conversation based on shared interests or a vibe you picked up.

*Example:* "Hey! Love the [location in one of her photos]. Been there myself! What’s your favorite thing to do in [location]?”

*Why it works:* It's low-pressure, shows you’re observant, and provides an easy conversation starter.

**2. The Playful Curiosity Approach**

If you’re feeling a bit bolder, you can lean into the lack of information with a playful question. This shows you're not afraid to be a little cheeky and invites her to share something about herself.

*Example:* "No bio, huh? Clearly, you're a woman of secrets. 😉 What’s one thing you’re surprisingly good at?”

*Why it works:* It’s lighthearted, breaks the ice, and demonstrates a sense of humor.

**3. The Direct & Engaging Question**

Sometimes, simplicity is key. Ask an open-ended question that encourages her to elaborate and reveals a bit about her personality.

*Example:* "What's one thing that's made you smile today?”

*Why it works:* It’s easy to answer, positive, and can lead to a genuine connection.

**Important Considerations:**

* **Profile Pictures:** Really analyze her pictures. Look for clues about her interests, hobbies, or travel destinations. This can provide valuable conversation starters.

* **Be Respectful:** Even if she has a minimal profile, treat her with respect and avoid making assumptions or being overly forward.

* **Don’t Be Discouraged:** It might take a few tries to get a response. Not everyone is active on dating apps or feels comfortable sharing a lot of information upfront.

Ultimately, the best message is one that is genuine, engaging, and shows you’ve taken the time to look at her profile (even if it's brief!). Good luck!">

3 Mensajes Efectivos para Enviar a una Mujer Sin Bio en una App de Citas

Have you ever stumbled upon a profile on a dating app that's… sparse? Like, really sparse? No bio, maybe a couple of pictures, and you're left wondering, “Is this a bot? A ghost? Or just someone who believes in letting their pictures do the talking?”

While a lack of information can be intriguing (a mystery!), it can also be a hurdle when it comes to sparking a connection. You don't have much to work with, so you need to be creative and strategic with your opening message.

Here are 3 effective messages to send a woman with no bio on a dating app, along with explanations of why they work:

**1. The Observational Opener**

This approach focuses on something you *did* notice about her profile – her photos. It shows you paid attention and allows you to start a conversation based on shared interests or a vibe you picked up.

*Example:* "Hey! Love the [location in one of her photos]. Been there myself! What’s your favorite thing to do in [location]?”

*Why it works:* It's low-pressure, shows you’re observant, and provides an easy conversation starter.

**2. The Playful Curiosity Approach**

If you’re feeling a bit bolder, you can lean into the lack of information with a playful question. This shows you're not afraid to be a little cheeky and invites her to share something about herself.

*Example:* "No bio, huh? Clearly, you're a woman of secrets. 😉 What’s one thing you’re surprisingly good at?”

*Why it works:* It’s lighthearted, breaks the ice, and demonstrates a sense of humor.

**3. The Direct & Engaging Question**

Sometimes, simplicity is key. Ask an open-ended question that encourages her to elaborate and reveals a bit about her personality.

*Example:* "What's one thing that's made you smile today?”

*Why it works:* It’s easy to answer, positive, and can lead to a genuine connection.

**Important Considerations:**

* **Profile Pictures:** Really analyze her pictures. Look for clues about her interests, hobbies, or travel destinations. This can provide valuable conversation starters.

* **Be Respectful:** Even if she has a minimal profile, treat her with respect and avoid making assumptions or being overly forward.

* **Don’t Be Discouraged:** It might take a few tries to get a response. Not everyone is active on dating apps or feels comfortable sharing a lot of information upfront.

Ultimately, the best message is one that is genuine, engaging, and shows you’ve taken the time to look at her profile (even if it's brief!). Good luck!">

Por qué la gente se comporta mal en las aplicaciones de citas – Causas, Psicología y Soluciones">

Por qué la gente se comporta mal en las aplicaciones de citas – Causas, Psicología y Soluciones">

Por qué los hombres no hacen preguntas: Guía para una mujer soltera">

Por qué los hombres no hacen preguntas: Guía para una mujer soltera">

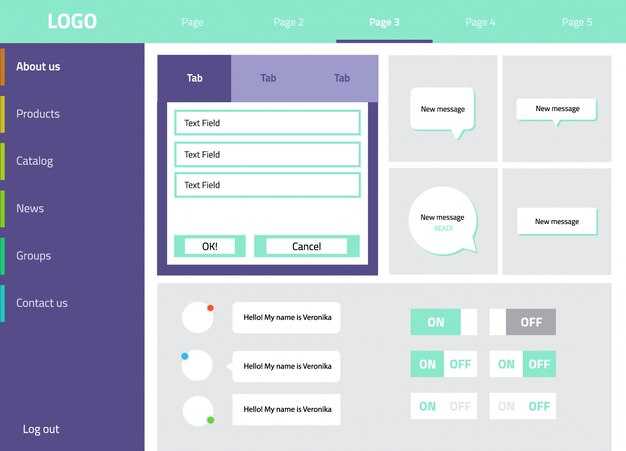

Ventana de diálogo – Diseño de la interfaz de usuario, ejemplos y las mejores prácticas de accesibilidad">

Ventana de diálogo – Diseño de la interfaz de usuario, ejemplos y las mejores prácticas de accesibilidad">

Superar la Codependencia – Consejos Prácticos para Liberarse">

Superar la Codependencia – Consejos Prácticos para Liberarse">